macOS 14 SonomaやiOS 17ではKyokoなどの合成音声を利用し文字入力した文章を読み上げてくれる「ライブスピーチ」機能が利用可能になっています。詳細は以下から。

![]()

Appleは2022年09月にリリースした「iOS 16」と「watchOS 9」で、アクセシビリティ機能の1つとしてiPhoneにペアリングされたApple WatchをiPhoneから操作できる「Apple Watchミラーリング」機能を追加しましたが、

Apple Watchミラーリング

2023年09月にリリースされた「iOS 17/iPadOS 17」や「macOS 14 Sonoma」では、同じくアクセシビリティ機能の1つとして新たに合成音声を利用し文字入力した文章を読み上げてくれる「ライブスピーチ (Live Speech)」機能が利用できるようになっています。

ライブスピーチ

ライブスピーチ機能はmacOS 14 SonomaまたはiOS 17、iPadOS 17以降を搭載したMacやiPhone, iPad以外に、watchOS 10以降を搭載したApple Watch Series 3以降など以下のデバイスで利用可能で、

ライブスピーチサポートデバイス

- Apple Silicon Mac

- iPhone XS以降

- iPad Air (第5世代)以降

- iPad Pro 11インチ (第3世代)以降

- iPad Pro 12.9 インチ (第5世代)以降

- Apple Watch Series 3以降

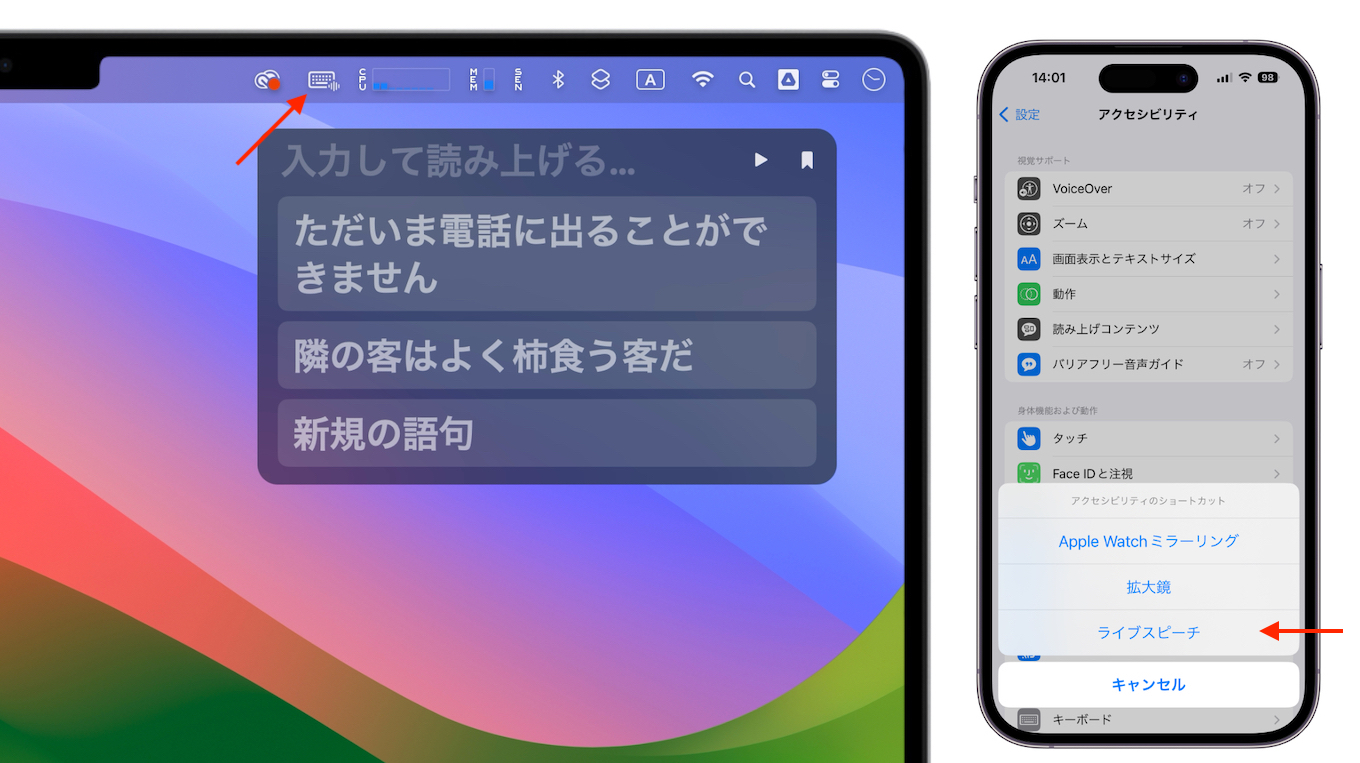

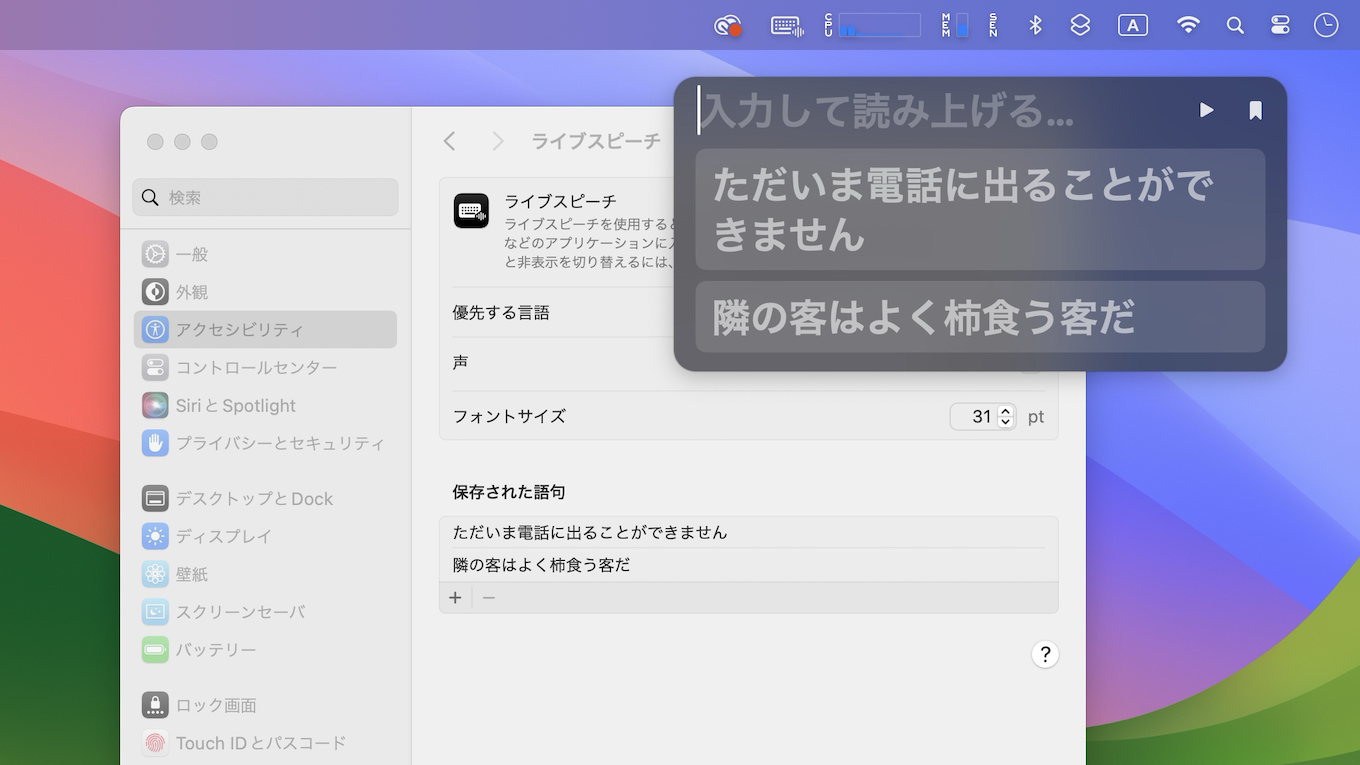

利用するには、macOS 14 Sonomaではシステム設定アプリの[アクセシビリティ] → [ライブスピーチ]から、iOS/iPadOS 17やwatchOS 10では設定アプリの[アクセシビリティ] → [ライブスピーチ]からライブスピーチ機能を有効にします。

ライブスピーチ機能で文字入力した文章を読み上げる音声はデフォルトではシステムボイス(Kyoko)ですが、その他のボイスファイルもダウンロードできるようになっており、日本語では男性の音声としてOtoyaとHattoriが、女性ではO-Renが追加できるようになっています。

読み上げる音声を設定したら、後はmacOS 14 Sonomaの場合はメニューバーに表示されるライブスピーチアイコンをクリック、iPhoneやiPadのではサイドボタンを3回クリック、Apple WatchではDigital Crownを3回クリックすることでライブスピーチウィンドウを表示し、文章を入力することが出来ます。

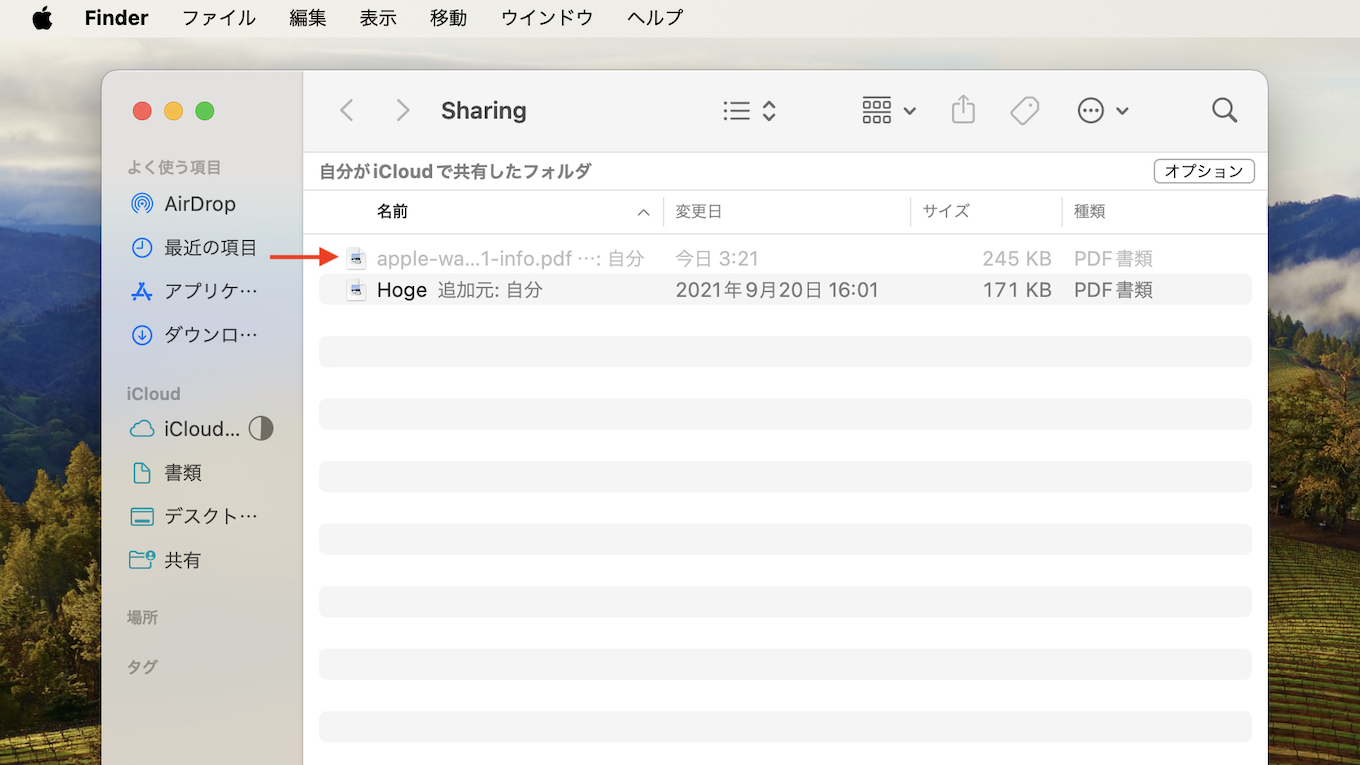

文章を入力し終えたら再生(▶)ボタンを押すだけで、先程設定したボイスで文章が読み上げられ、よく使う文章は保存しシステム設定/設定アプリで管理することが可能です。

これまでもユーザーが入力した文章を読み上げてくれる(Speak Text)機能はmacOSやiOSに実装されていましたが、ライブスピーチ機能はFaceTimeや電話アプリと統合されており、通話相手は入力された文章の読み上げを聞くことが出来るので、声が出せない状況で相手に音声を伝いたい方は試してみてください。

FaceTime または電話 アプリを使用している場合、通話相手は読み上げの内容を聞くことができます。それ以外の場合、iPhoneのスピーカーから読み上げの内容が聞こえます。

iPhoneのライブスピーチでタイプ入力して読み上げる – Apple

コメント