OpenAI、16GBメモリのMacでも使えるオープンウェイトの大規模言語モデル「gpt-oss-20b」などを公開しています。詳細は以下から。

![]()

米OpenAIは2025年08月05日、一般的なベンチマークでOpenAI o3‑miniと同等の結果を出し、わずか16GBのメモリを搭載したデスクトップやノートPCで動作するオープンウェイトの言語モデル「gpt-oss-20b」と、単一のNVIDIA H100 GPUなど80GB GPUで動作する「gpt-oss-120b」をリリースしたと発表しています。

低コストで強力な実世界パフォーマンスを実現する2つの最先端のオープンウェイト言語モデルの gpt-oss-120b と gpt-oss-20b をリリースします。Apache 2.0 ライセンスの下で利用可能なこれらのモデルは、推論タスクにおいて同規模の open model よりも優れたパフォーマンスを発揮し、強力なツール使用機能を備えており、一般的に広く使用されているハードウェア上での効率的な展開のために最適化されています。

gpt-oss が登場 – OpenAI

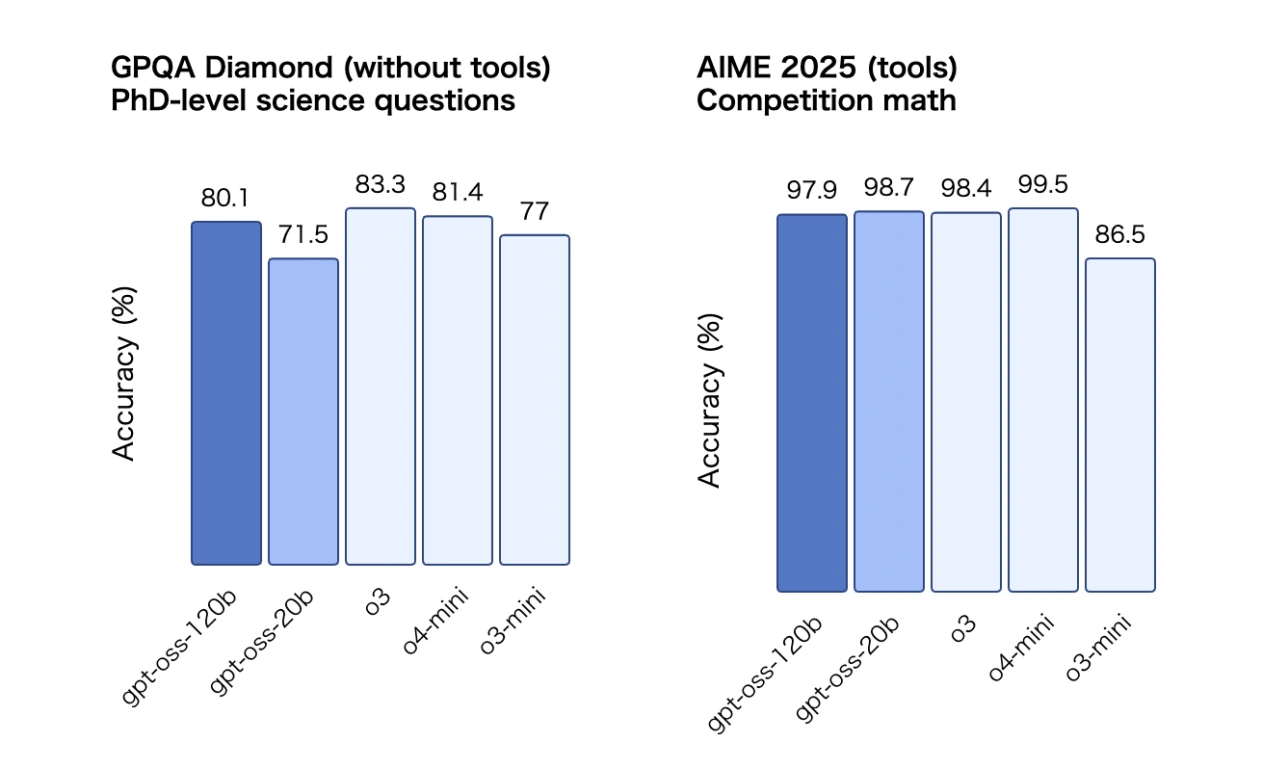

gpt-oss-20bは最近のMacやPCなどリソースが限られた環境でも利用できるよう、約211億パラメータを推論使用時には約36億まで削減して使用するMoE(mixture-of-experts)を活用しており、STEMやコーディング、一般知識に重点を置いた英語のテキストデータで学習されたモデルで、博士課程レベルの科学知識(GPQA)やAIME(数学試験)ではo3‑miniと、gpt-oss-120bはo4-miniに並ぶ精度となっています。

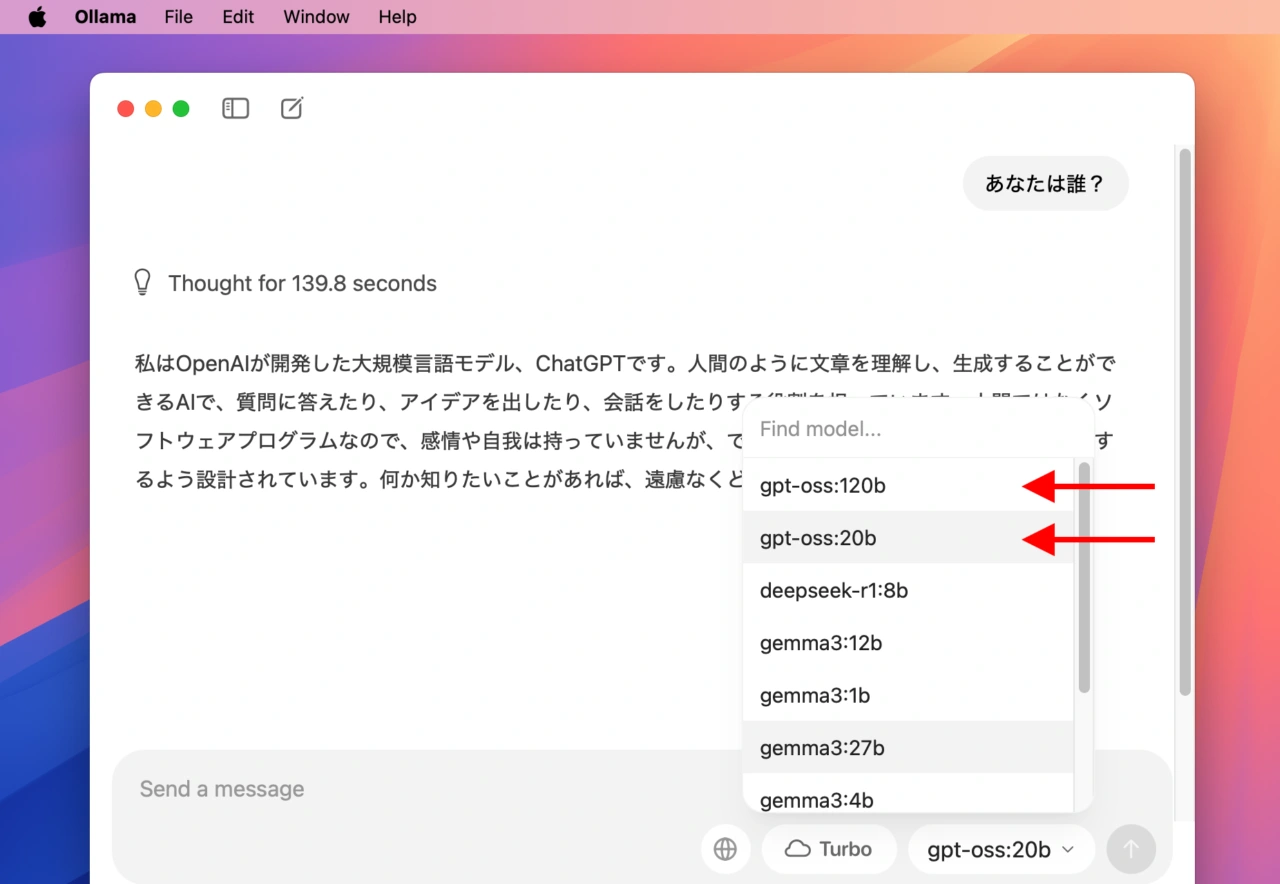

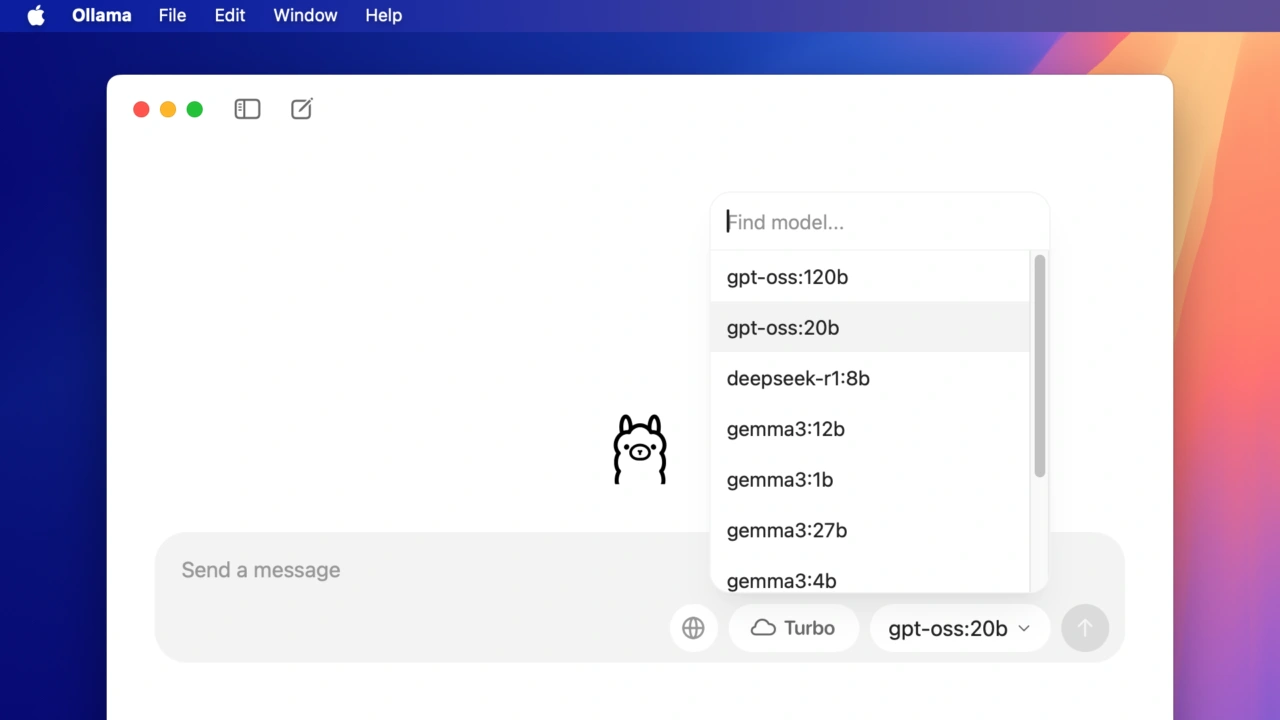

gpt-oss-20b/-120bはApache 2.0ライセンスで公開されているため商用利用も可能なためクラウドLLMやDeepSeekなどが許可されていない環境でも、Hugging Faceからダウンロードしオンプレミスで利用できる他、ローカルLLM管理ツール「Ollama」も既に対応しているので、Ollama CUI&GUIで利用できるようになっています。

Ollama gpt-oss:20b

16GBメモリのMacでも使える

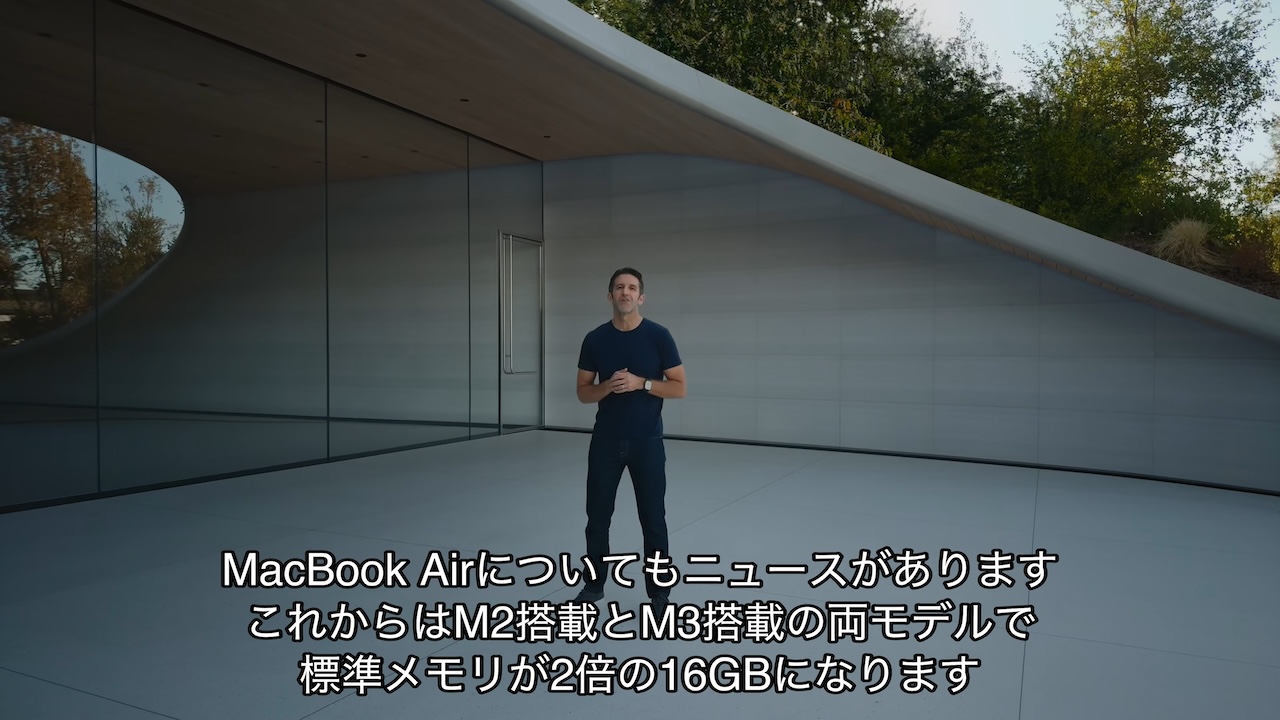

なお、Appleは2024年10月にApple M4ファミリーのMac mini/iMacやMacBook Air/Proを発表した際、これまで8GBユニファイドメモリが標準だったMacで、よりApple Intelligenceを快適に利用できるよう、価格を据え置きながらユニファイドメモリのベース容量を8GBから16GBへアップデートしているので、

値段据え置きでメモリが2倍にアップデートされたMacBook Air M2/M3

それ以降に購入したMacなら「gpt-oss-20b」が問題なく使えますが、モデルファイルのダウンロードサイズは約12GBで、以下の通りApple M4チップと16GBユニファイドメモリ搭載のMac miniでもメモリ(RAM)使用率がギリギリで、

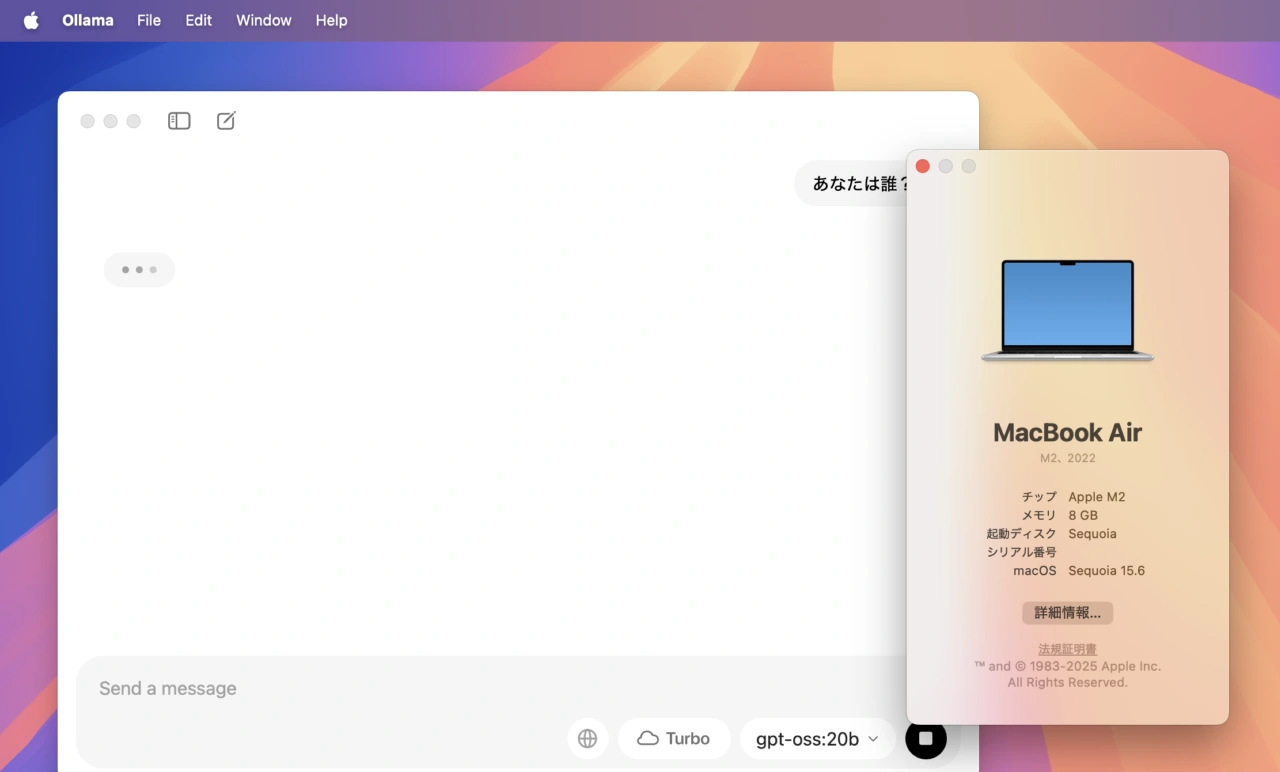

Apple M2チップと8GBユニファイドメモリ搭載のMacBook Airではスワップが10GB以上作成されOllamaが反応しなくなたので、8GBユニファイドメモリ搭載のの古いMac miniやiMac、MacBook Airをお使いの方は注意してください。

Apple M2と8GBユニファイドメモリのMacBook Air

- gpt-oss が登場 – OpenAI

- openai/gpt-oss-20b/-120b – Hugging Face

- openai/gpt-oss: gpt-oss-120b and gpt-oss-20b are two open-weight language models by OpenAI – GitHub

コメント

確かに16GBでも動きますが対話を始めるとしばらくメモリーを使い切るので、もう少しメモリーがないと対話を満足にできないようです。24GB以上ないと厳しそうです。実感では