大規模言語モデルとの対話が可能な新しいmacOS/Windowsアプリを実装したローカルLLM管理ツール「Ollama v0.10.0」がリリースされています。詳細は以下から。

![]()

米カリフォルニア州のOllama, Inc.は現地時間2025年07月31日、MacやPC、Linuxなどのローカル環境で大規模言語モデル(LLM)セットアップできるオープンソースのLLM管理ツール「Ollama」の最新バージョンとなる「Ollama v0.10.0」をリリースし、同バージョンでLLMの管理機能だけでなく対話UIを追加したと発表しています

Ollama’s new app

Ollama’s new app is available for macOS and Windows.Ollama for macOS v0.9.5のリリースノートより

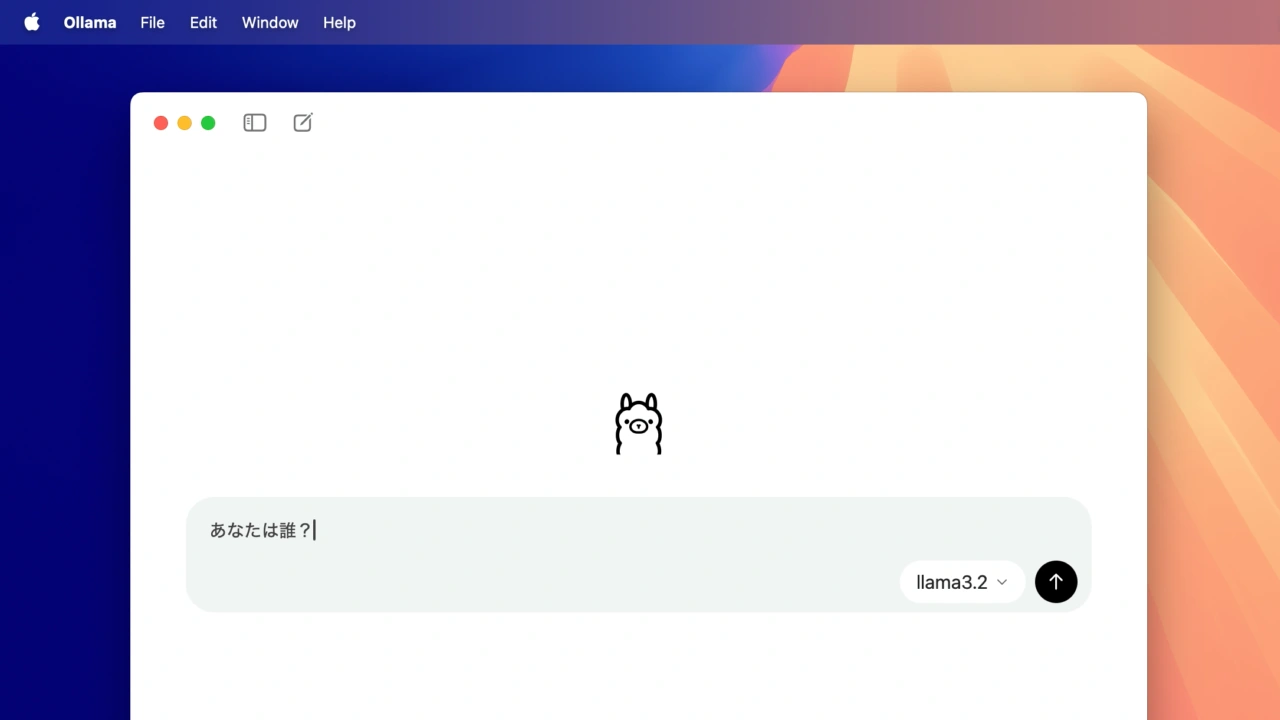

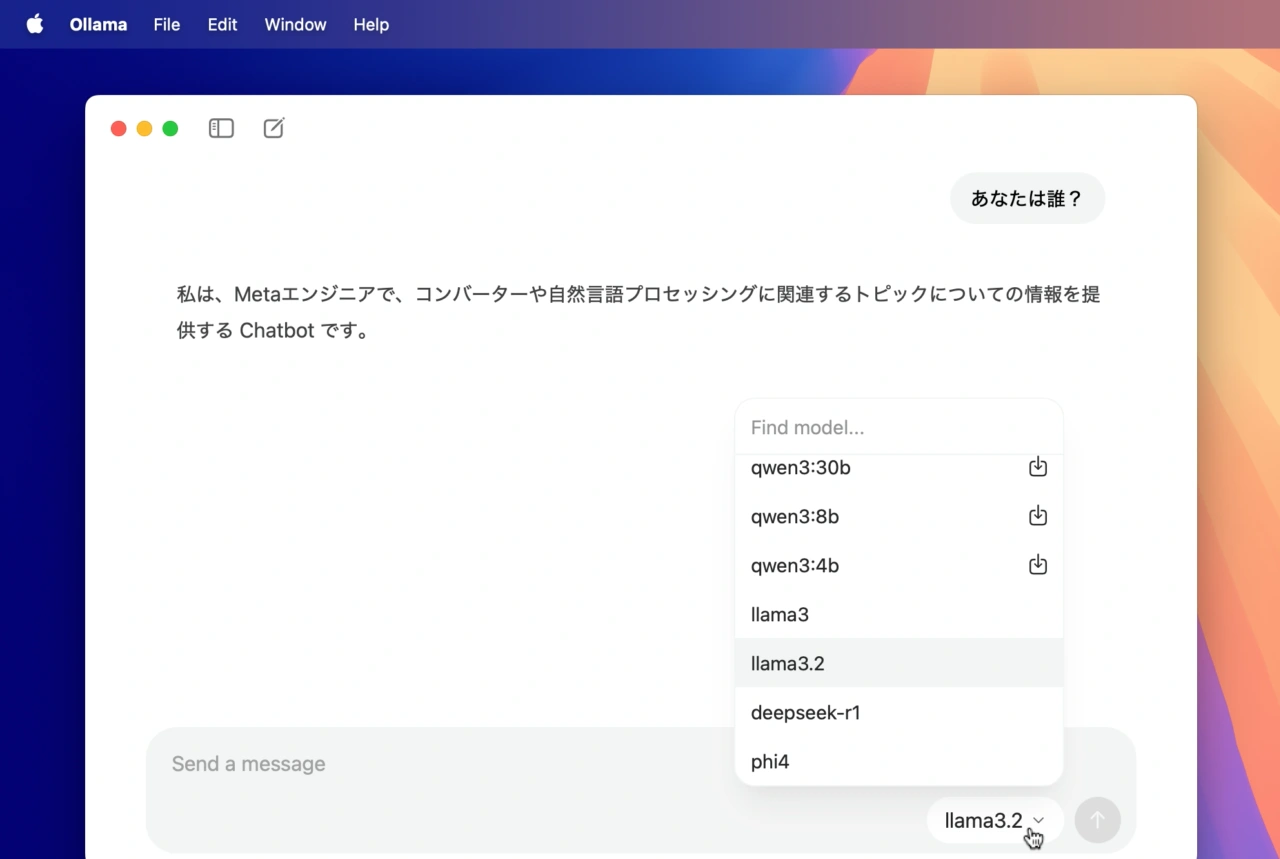

Ollamaは07月03日にリリースされた「Ollama v0.9.5」で、macOSアプリがElectron製からmacOSネイティブに刷新され、アプリケーションサイズが約4分の1になり、アプリの起動が大幅に高速化されていましたが、OllamaのメンテナーであるMatt Williamsさんによると、Ollama v0.10.0ではLM Studioのような複雑なGUIでなく、シンプルな対話ウィンドウ(UI)が実装され、ダウンロードしたAIモデルと直ぐに対話を開始することが可能になったそうです。

また、Ollama v0.10.0の新しいアプリはファイルのドラッグ&ドロップにも対応し、テキストファイルやPDFファイルを読み込んで解析できる他、ソースコードファイルを読み取り解析やコードの説明、修正を行うことも可能で、

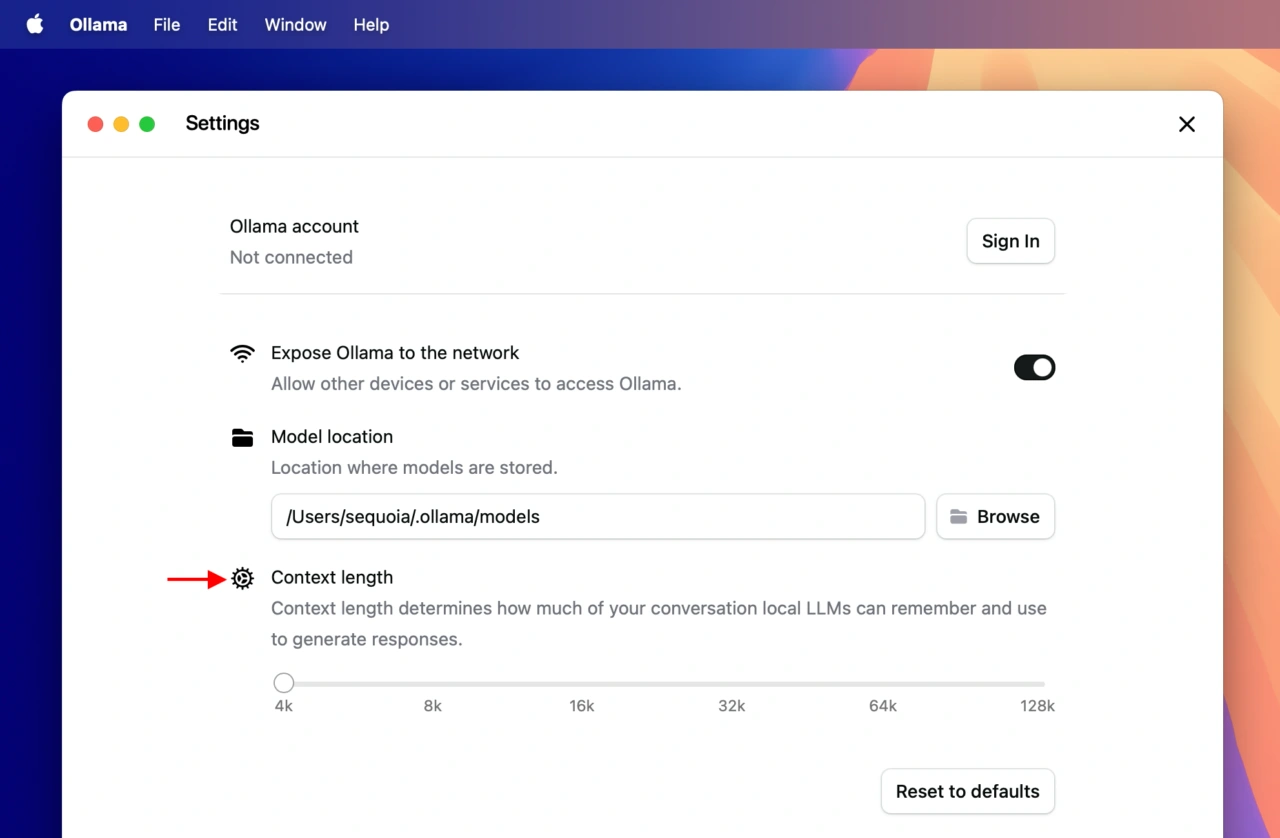

新しいマルチモーダルエンジンを搭載し画像をサポートするGoogle DeepMindのGemma 3などに画像を送信することも可能になっており、ローカルLLMの管理機能だけでなく対話アプリとしての機能も追加されたことで、[Settings…]にはローカルLLM(AIモデル)が会話中にどれだけのトークンを記録/処理するかを決定できる設定が追加されています。

この他、Ollama v0.10.0では、ollama psコマンドでロード中のモデルのコンテキスト長を表示できる機能が追加され、Gemma3nのパフォーマンスが2~3倍向上、OpenAI互換APIでWebP画像のサポートなどCLI/バックグラウンドエンジンも改善されて、今はまだ詳細は伏せられていますが新サービス用に[Ollama Account]へのログインも可能になっているので、ローカルLLMを使ってみたい方は試してみてください。

Ollama v0.10.0 New features

- ollama ps will now show the context length of loaded models

- Improved performance in gemma3n models by 2-3x

- Parallel request processing now defaults to 1. For more details, see the FAQ

- Fixed issue where tool calling would not work correctly with granite3.3 and mistral-nemo models

- Fixed issue where Ollama’s tool calling would not work correctly if a tool’s name was part of of another one, such as add and get_address

- Improved performance when using multiple GPUs by 10-30%

- Ollama’s OpenAI-compatible API will now support WebP images

- Fixed issue where ollama show would report an error

- ollama run will more gracefully display errors

コメント