ローカルLLM管理ツール「Ollama」が次期アップデートで新しいmacOS/Windowsアプリを導入すると発表しています。詳細は以下から。

![]()

Ollamaは、米カリフォルニア州のOllama, Inc.がオープンソースで開発しているMacやPC、Linuxなどのローカル環境で大規模言語モデル(LLM)を使えるよう、ダウンロードや実行/管理を行うことが出来るLLM管理ツールですが、このOllamaが次期バージョンv0.9.4アップデートで、macOSとWindows向けに新しいアプリをリリースするそうです。

A new version of Ollama’s macOS and Windows applications are now available. New improvements to the apps will be introduced over the coming releases:

Ollama v0.9.4 RCのリリースノートより

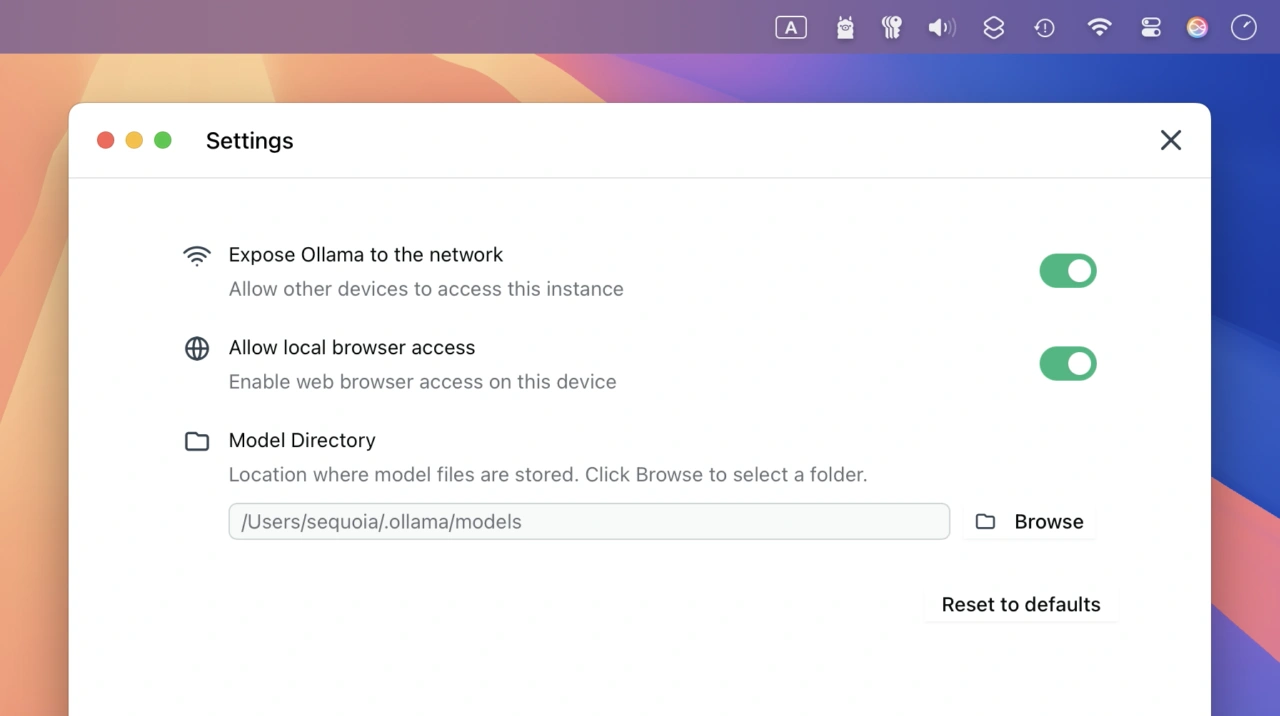

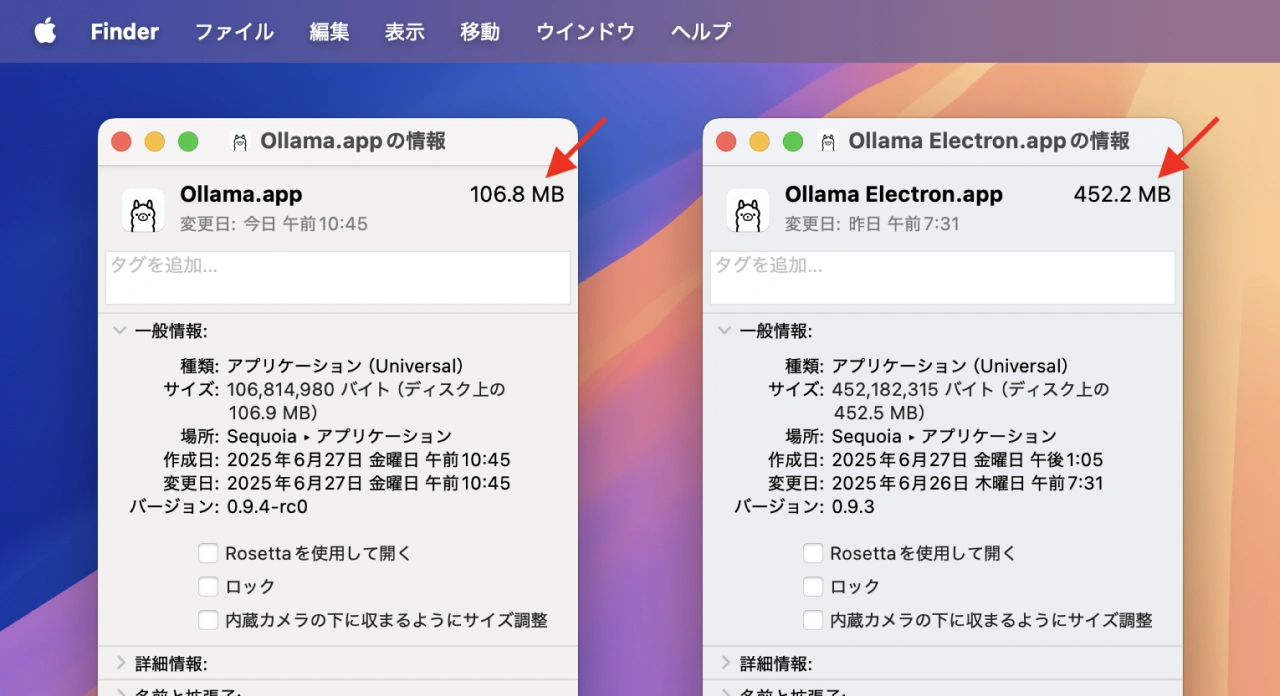

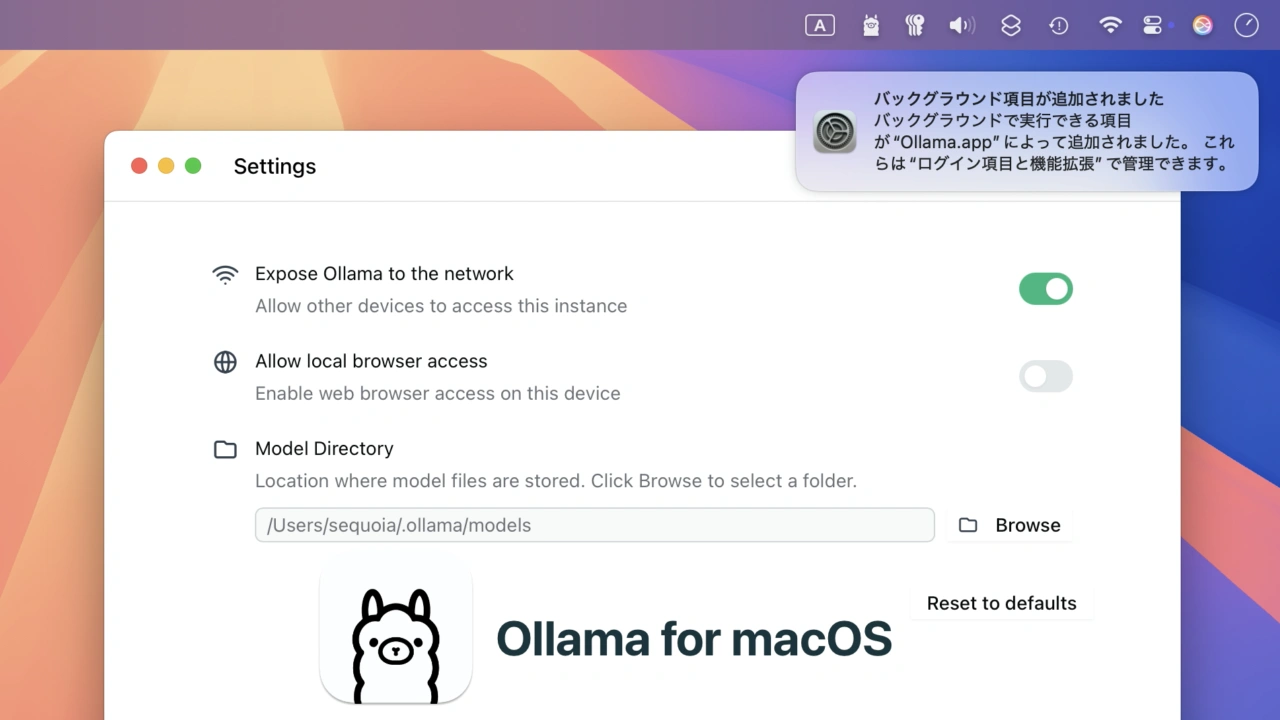

Ollama v0.9.4 RCのリリースノートによると、Ollama v0.9.4ではOllamaで構築した環境をネットワーク上に公開/共有できるようになる他、ollama-jsなどブラウザベースのアプリ開発に便利なブラウザアクセス、LLMのダウンロードフォルダの変更がGUIで行えるようになり、更にmacOSアプリはElectronアプリからmacOSネイティブアプリに刷新されるため、アプリケーションサイズが小さくなり起動が高速化されているので、気になる方はRC版をチェックしてみてください。

Ollama v0.9.4 RC (約106.8MB)とOllama v0.93 (約452.2MB)

Ollama v0.9.4 New features

- Expose Ollama on the network

▶Ollama can now be exposed on the network, allowing others to access Ollama on other devices or even over the internet. This is useful for having Ollama running on a powerful Mac, PC or Linux computer while making it accessible to less powerful devices. - Allow local browser access

▶Enabling this allows websites to access your local installation of Ollama. This is handy for developing browser-based applications using Ollama’s JavaScript library. - Model directory

▶The directory in which models are stored can now be modified! This allows models to be stored on external hard disks or alternative directories than the default. - Smaller footprint and faster starting on macOS

▶The macOS app is now a native application and starts much faster while requiring a much smaller installation.

コメント