Apple MLXを利用したiPhone/iPad用ローカルAIクライアント「Locally AI」がMacに対応しています。詳細は以下から。

![]()

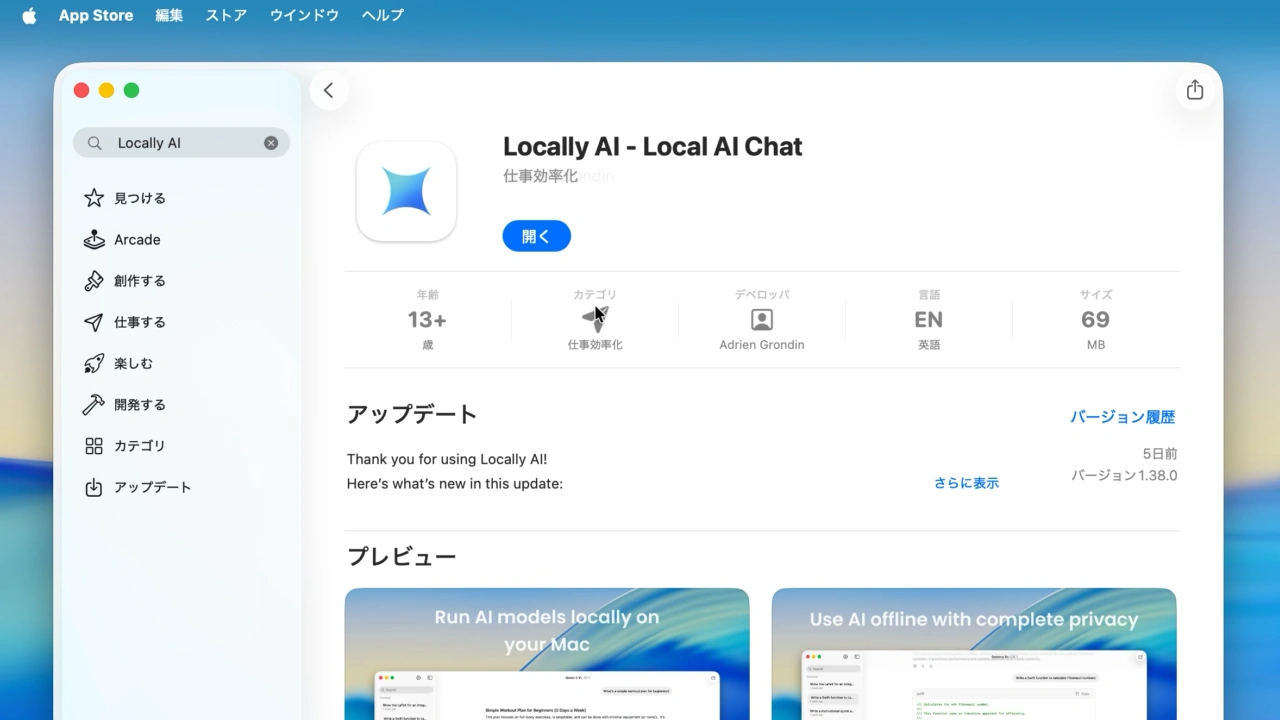

Locally AIはマッッチングサイトTinderなどを運営する米Match Group Inc.でiOSアプリを開発するAdrien Grondinさんが、iPhone/iPad向けに開発したローカルAIクライアントで、LamaやGemma, QwenなどのモデルをダウンロードしてiPhone/iPad上で実行できますが、このLocally AIがMacに対応しています。

![]()

Run Al models like Lama, Gemma, Qwen, and more on your iPhone and iPad. Offline. Private. No login. No data collection. Powered by Apple MLX.Meet Locally Al, the Al app that respects your privacy. No login. No data collection. Just pure intelligence, running entirely on your iPhone and iPad.

Locally AI – App Store

Locally AIはAppleの機械学習フレームワークApple MLXを利用し、Apple Siliconに最適化されており、Ollamaなど他のAIクライアントと同じくLamaやGemma, SmolLM、DeepSeek、QwenなどのAIモデルをワンクリックでHugging Faceからダウンロードしてローカルで実行できるようにしてくれます。

![]()

また、先日リリースされたLocally AI v1.35/1.38では、Qwen 3 VL 2BモデルやIBM Granite-4.0-H-1Bと350Mに加え、iOS/iPadOS 26でサポートされた「Apple Foundation Model」*にも対応しており、アプリのシステム要件はmacOS 26.0 Tahoe以降のMacとiOS/iPadOS 18.0以降のiPhone/iPadとなっており、アプリは無料でApp Storeに公開されているので、気になる方は試してみてください。

Analyze images with Locally AI on your Mac using the latest Qwen 3 VL models by @Alibaba_Qwen 📷

Running privately on your device and powered by Apple MLX. pic.twitter.com/YR8iNExQKc

— Locally AI – Local AI Chat (@LocallyAIApp) November 3, 2025

- Locally AI – App Store

- Run AI models locally on your iPhone. – Locally AI

コメント