オープンソースのローカルLLMクライアント「Fullmoon for iOS/macOS/visionOS」がリリースされています。詳細は以下から。

![]()

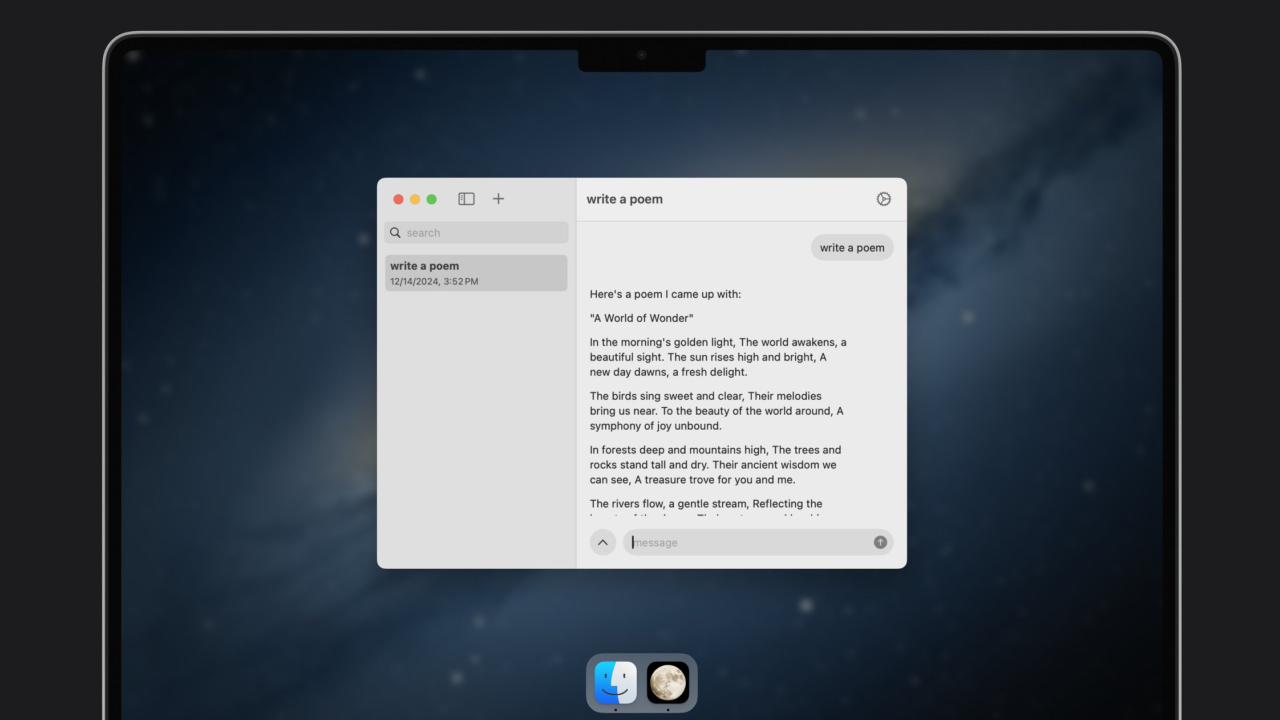

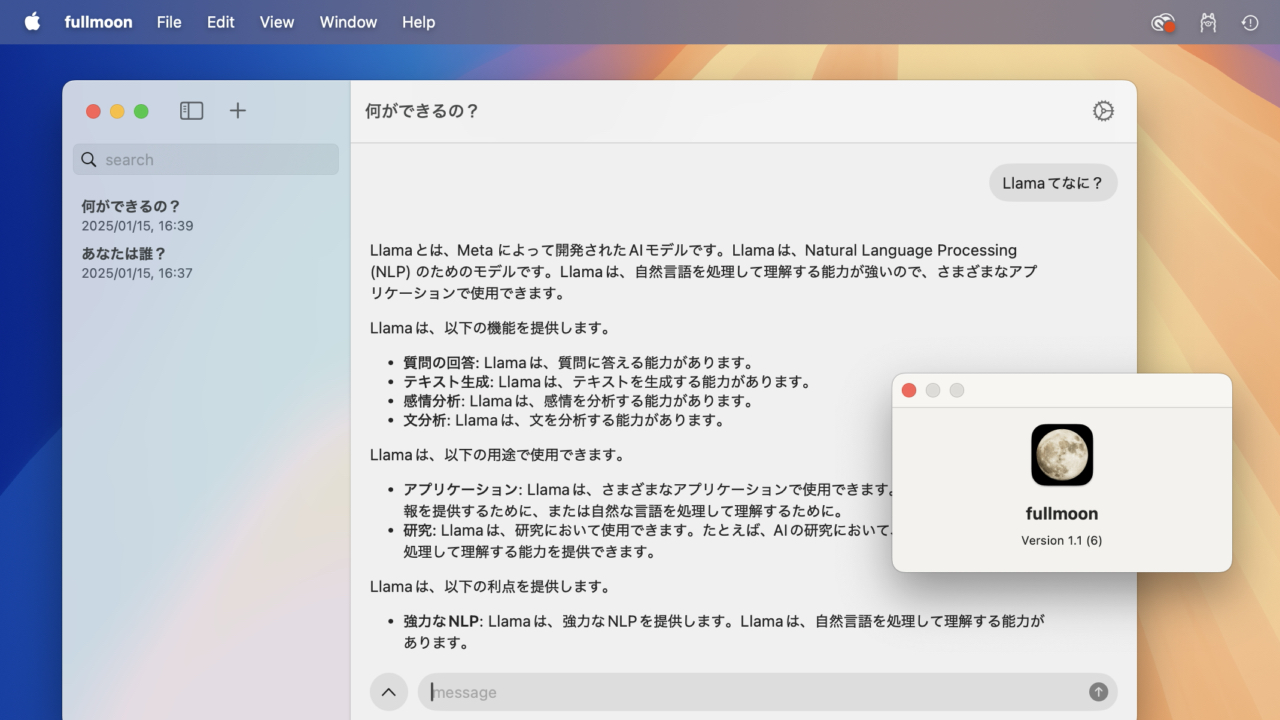

元MetaのShivkanth Bagavathyさんらが設立したMainframe Computer, Inc.は現地時間2025年01月14日、iPhoneやMac、Vision Pro上でプライベート&ローカルに大規模言語モデル(LLM)を動作させることができるクライアント「fullmoon」を新たにリリースしたと発表しています。

a billion parameters in your pocket: use fullmoon to chat with private and local large language models like llama 3.2.

the simplest way to use private LLMs: works fully offline and private when you don’t have internet. runs models on-device optimized for Apple silicon.works on every platform: iOS, iPadOS, macOS, visionOSfullmoon: local intelligence – App Store

Mainframe Computer, Inc.のJordan Singerさんによると、fullmoonはApple Siliconに最適化されたAppleのMLX (MLX Swift)フレームワークとを利用したLLMクライアントで、iOSやiPadOS、macOS、visionOSに対応しており、アプリのテーマやフォント、システムプロンプトを設定可能で、

today, on this full moon, we're launching @fullmoonapp on the App Store 🌕 it's the simplest way to use local LLMs like Llama

after a few months of testing, we've adapted it natively to all platforms including iPhone, iPad, Mac, and Vision

it's completely free and fully open… pic.twitter.com/MnPtrxbCiv

— Jordan Singer (@jsngr) January 13, 2025

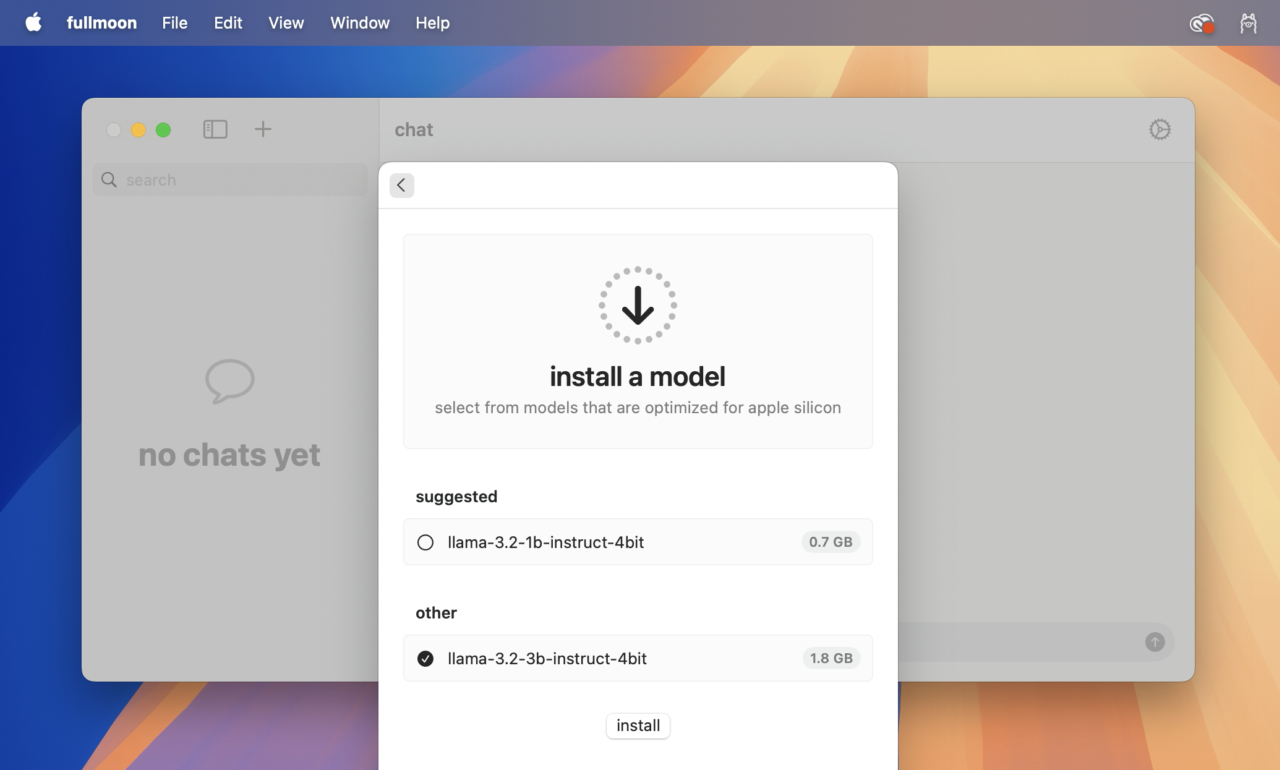

現在のところサポートしているローカルLLMはMetaのLlama 3.2 1B(10億)と3B(30億)パラメータのみですが、ソースコードはオープンソース(MIT)で公開されており、アプリもAppleのApp Storeに無料で公開されています。

fullmoonのシステム要件はiOS/iPadOS 17.6以降のiPhoneとiPad、macOS 14 Sonoma以降のApple Silicon Mac、visionOS 2.0以降のVision Proとなっているので、興味のある方は試してみてください。

- fullmoon: local intelligence – App Store

- fullmoon: local intelligence – fullmoon.app

- fullmoon : chat with private and local large language models – GitHub

コメント