iOS 12で採用されるARKit 2の「Face Tracking」を利用し、視線でiPhone Xを操作するデモが公開されています。詳細は以下から。

![]()

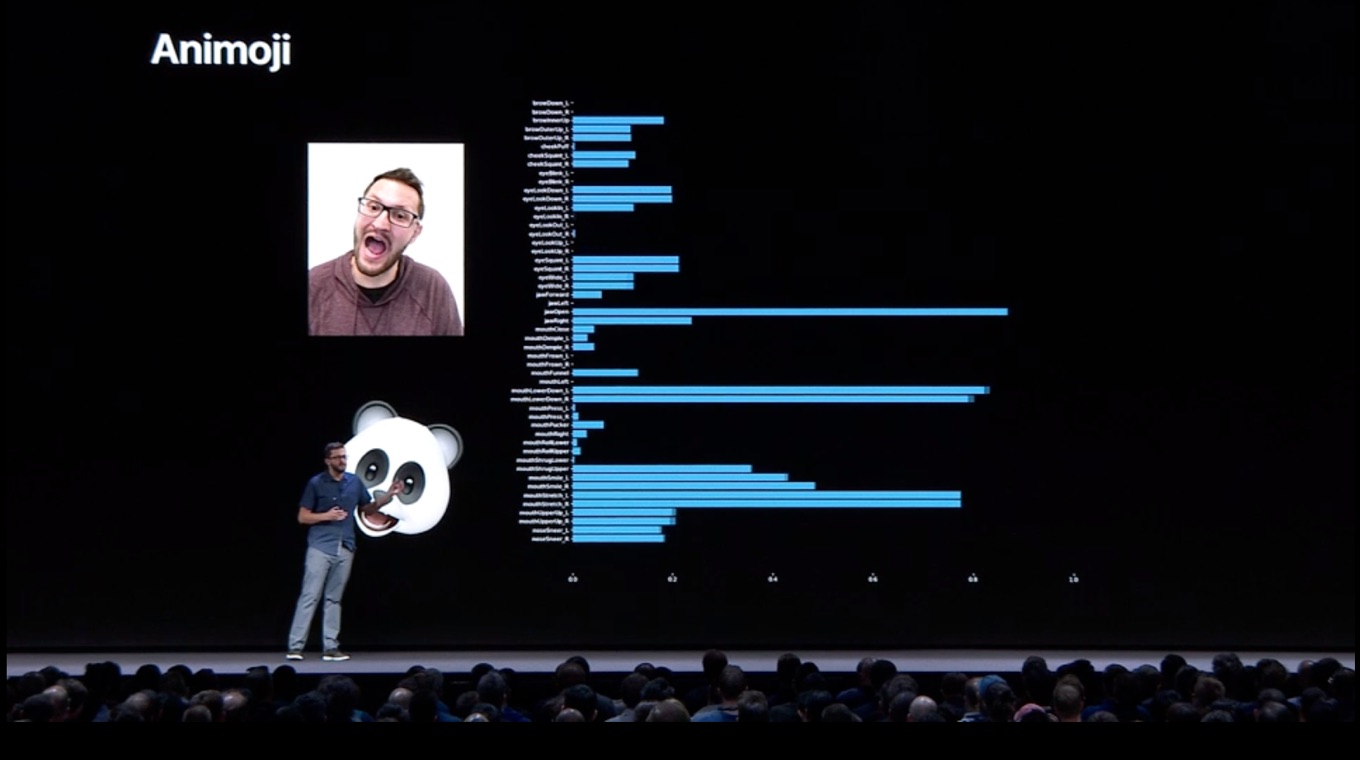

AppleはWWDC 2018の基調講演の中で、iOS 12から採用されるARKit 2の「Face Tracking」には、iPhone XのFace IDを利用してユーザーの舌とウィンクを検知する技術があり、新しいAnimojiやMemojiはこれをサポートし、新しいジェスチャーが利用できると紹介しましたが、

新しいアニ文字や、カスタマイズ可能で楽しいパーソナライズされたミー文字キャラクターで、iPhone Xから友達や家族に向けたコミュニケーションがより表現力に富んだものになります。[…]すべてのアニ文字とミー文字にはウィンクと舌検知が搭載され、これまで以上に様々な表情を捉えることができるようになりました。

Apple、 iOS 12をプレビュー – Apple (日本)

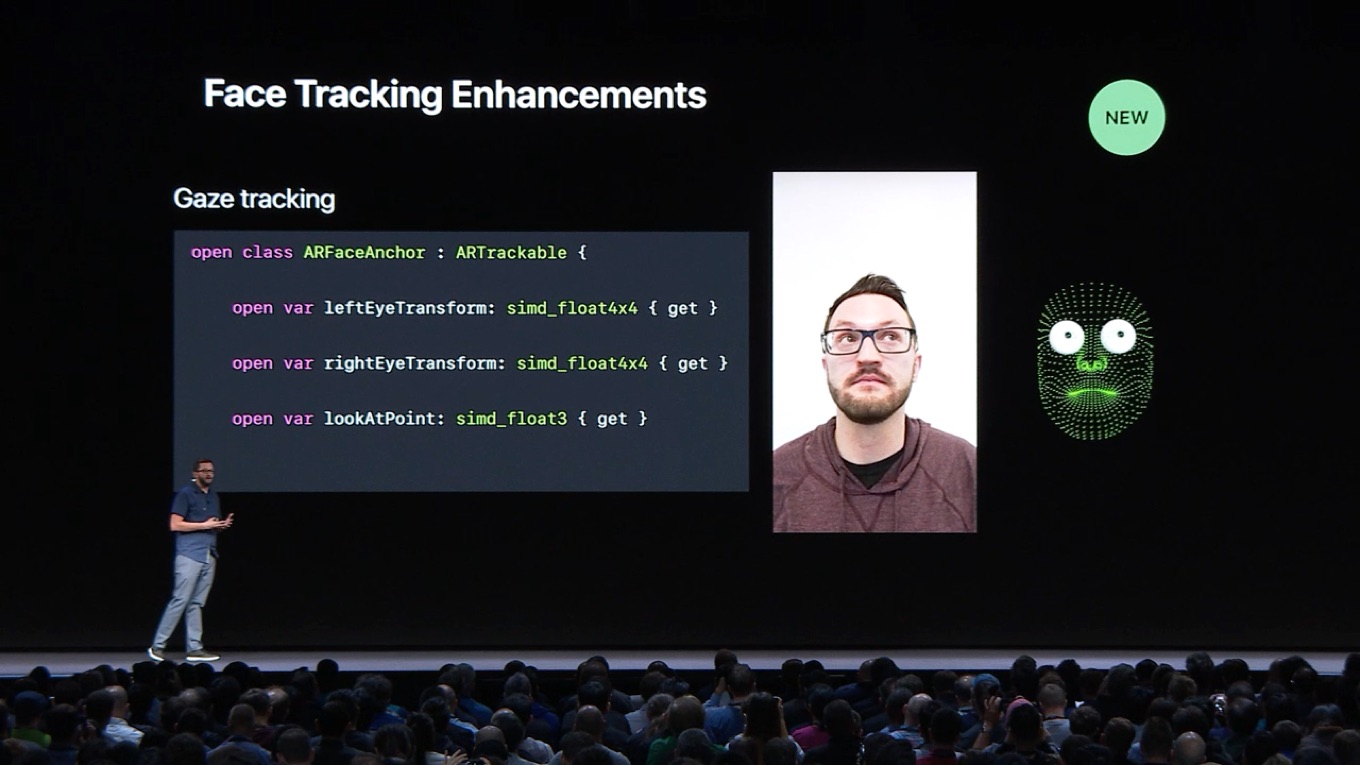

このARKit 2のセッション 602 “What’s New in ARKit 2”によると、ARKit 2にはウィンクだけでなくユーザーの視線を認識する「Gaze Tracking」技術があり、これを利用してiPhone Xを目だけで操作するデモが公開されています。

![]()

Gaze TrackingによるiPhone Xの操作方法を公開したのはWWDC Student ScholarのMatt Mossさんで、以下の動画のように視線でボタンを選択し、ウィンクでボタンをタップするというWindows 10の視線制御やmacOS 10.12 SierraのDwell Controlの様な機能が実装できるそうなので、興味のある方はチェックしてみて下さい。

コメント

素晴らしい。アクセシビリティに組み込んで欲しい。